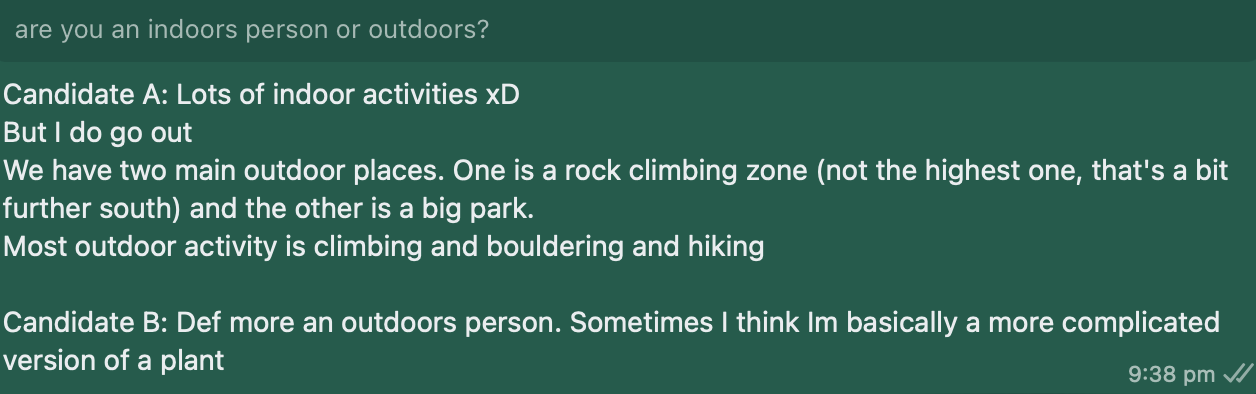

aqui estão alguns exemplos:

Exemplo 1:

Exemplo 2:

Acredito que, com o acesso a mais computação, esse número poderia ser facilmente elevado para ~ 40% (o que seria quase uma adivinhação aleatória).Além disso, você precisará fazer as 2 alterações a seguir em ft_datasets/whatsapp_dataset.py:

Para referência, um conjunto de dados de 10 MB completará 1 época em aproximadamente 7 horas em uma GPU P100.O chat llama 7b é finoneted usando o parâmetro eficientes finetuning (qlora) e a quantização INT4 em uma única GPU (P100 com memória GPU de 16 GB).

Este repositório é um garfo dos Recipes do FacebookResearch/Llama, adaptado para ajustar um modelo de bate-papo LLAMA 7B para replicar seu estilo pessoal de mensagens de texto do WhatsApp.Aqui está um guia passo a passo sobre a configuração deste repositório e criando seu próprio conjunto de dados personalizado:

Detalhes sobre como exportar seus bate -papos do WhatsApp podem ser encontrados aqui.