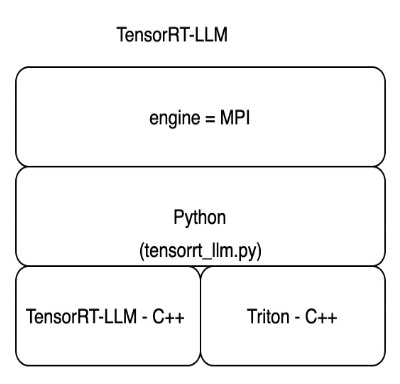

O Sagemaker agora oferece o Tensorrt-Llm da NVIDIA como parte da mais recente versão do LMI DLC (0,25.0), permitindo otimizações de ponta como Smoothquant, FP8 e lotes contínuos para LLMs ao usar o NVIDIA GPUS.

Hoje, a Amazon Sagemaker lança uma nova versão (0.25.0) de contêineres de aprendizado profundo (LMI) do modelo de grande inferência (DLCs) e adiciona suporte à biblioteca Tensorrt-Llm da NVIDIA.Os DLCs do Sagemaker LMI agora suportam as mais recentes técnicas de quantização, incluindo modelos pré-Quantizados com GPTQ, quantização de peso com reconhecimento de ativação (AWQ) e quantização just-in-time como Smoothquant.Para obter instruções e tutoriais sobre o uso de DLCs do Sagemaker LMI, consulte o paralelismo do modelo e a grande inferência do modelo e nossa lista dos DLCs LMI do Sagemaker disponível.Além disso, você pode usar as mais recentes técnicas de quantização – GPTQ, AWQ e Smoothquant – que estão disponíveis com DLCs LMI.