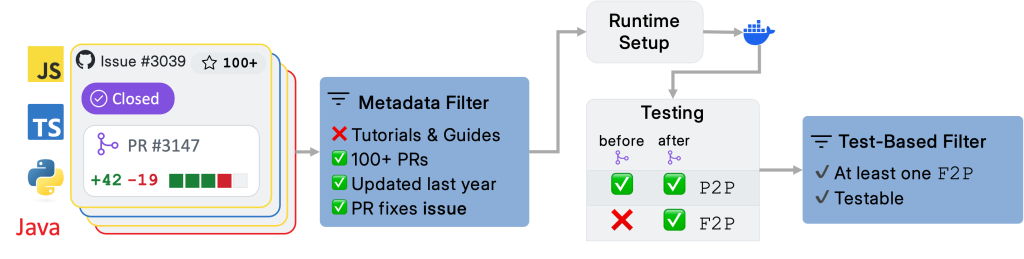

Abaixo, descrevemos os principais recursos, características e o processo de criação do nosso conjunto de dados, juntamente com as novas métricas de avaliação e o desempenho de agentes de código aberto de nossos experimentos.Figura 1: Visão geral do pipeline de geração de dados do SWE-PolyBench, ilustrando o processo de coleta, filtragem e validação de tarefas de codificação.O Data Aquisition Pipeline coleta solicitações de tração (PRs) que fecham questões de repositórios populares em Java, JavaScript, Typescript e Python.O SWE-Bench, uma referência para a geração de código Python, avalia os agentes em tarefas de programação do mundo real, utilizando problemas do GitHub e suas modificações correspondentes de código e teste.Ele contém apenas repositórios Python, a maioria das tarefas são correções de bugs e, em mais de 45% de todas as tarefas, o repositório do Django é significativamente super-representado.